Dieser Beitrag baut auf dem Artikel „Künstliche Intelligenz (KI) und KI-Anwendungen – was ist das?“ auf und nimmt dessen grundlegende Definitionen sowie Einordnungen als Ausgangspunkt. Hinweis zur Entstehung: Dieser Artikel wurde mit Hilfe von ChatGPT‑5 verfasst.

Oberstleutnant i.G. Maximilian Harhausen

Zwei Perspektiven auf KI in der Bundeswehr

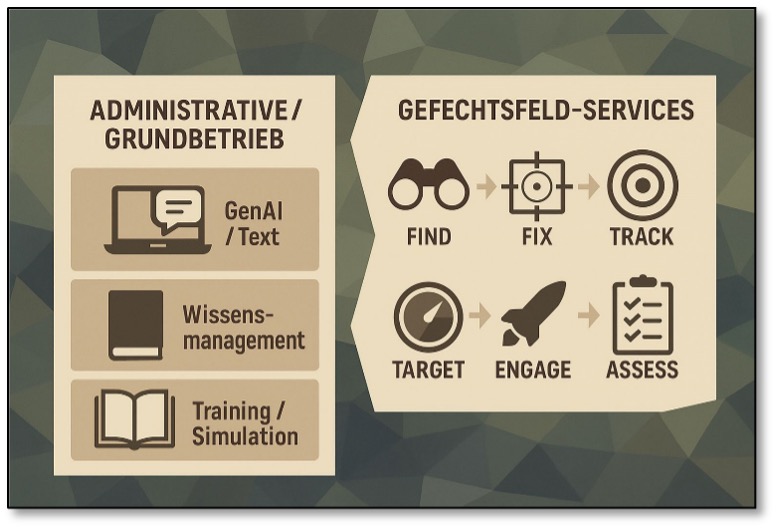

Künstliche Intelligenz (KI) ist nicht „eine“ Technologie, sondern ein Bündel von Verfahren und Anwendungen, die Muster erkennen, Prognosen liefern oder automatisierte Assistenzfunktionen bereitstellen. Im Kontext der Streitkräfte sind zwei Einsatzbereiche klar zu unterscheiden: Erstens administrative und betrieblich-organisatorische Anwendungen im Grund- oder Friedensbetrieb (Büro, Logistik, Personalwesen, Ausbildung), die bereits heute in vielen Organisationen eingesetzt werden; zweitens taktische und operationelle Gefechtsfeld-Services, bei denen KI-Funktionen die Wahrnehmung, Analyse, Entscheidungs- und Wirkketten unterstützen — mit aller gebotenen Vorsicht hinsichtlich Sicherheits‑, rechtlicher und ethischer Grenzen.

KI-Perspektiven in der Bundeswehr, Grapik: Generiert mit ChatGPT

Verwaltungs- und Büroanwendungen

In den Büro-Bereichen der Bundeswehr werden KI-gestützte Werkzeuge ab 2026 zum integralen Bestandteil des Arbeitsalltags. In der (datenschutz- und informationssicherheitskonformen) Beschaffung befinden sich dazu derzeit: Generative KI (GenAI) für Text- und Dokumentenarbeit zur Unterstützung beim Formulieren von Berichten, Protokollen, Standard-E-Mails, Zusammenfassungen langer Dokumente oder beim Erstellen von Vorlagen. Solche Systeme sparen Zeit und erhöhen die Konsistenz von Arbeitsprodukten, sofern die Ausgabe durch Menschen geprüft und unverändert verantwortet wird. Beim Informations- und Wissensmanagement soll zukünftig die semantische Suche, automatische Verschlagwortung, Extraktion relevanter Informationen aus großen Dokumenten-Korpora (Stichwort: Regelungslandschaft) mit KI-Systemen unterstützt werden, was die Auffindbarkeit von Vorschriften, Richtlinien, Weisungen und Technikdokumentation deutlich verbessern wird. Ebenfalls in Untersuchung sind Aspekte der Aus- und Weiterbildung wie adaptive Lernplattformen, die Lernstände analysieren und individuelle Übungspläne vorschlagen oder Simulationen, die Routine-Trainings effizienter machen.

Diese Anwendungen sind in der Regel nicht in dem Maße sicherheitskritisch wie es Waffensystemen sind, sie unterliegen aber Datenschutz‑, Geheimschutz- und Betriebs-IT-Vorgaben, was ihre Beschaffung und Integration alles andere als trivial macht. Solche Dienste müssen zentral gesteuert, gehärtet und Verantwortlichen klar zugeordnet werden (Datenschutzbeauftragte, Betriebsverantwortliche, Informationssicherheitsverantwortliche).

Klare Bedingung für den Einsatz im administrativen Bereich ist dabei besonders die Datenhoheit: Sensible und geheime Daten dürfen nicht ungeprüft in öffentliche Cloud-GenAI-Dienste (wie bspw. ChatGPT) gelangen. Auch müssen generierte Inhalte, dort wo dies im Rahmen der Hochautomatisierung vertretbar ist, durch Menschen validiert werden — unbeaufsichtigte Freigaben sind mit den damit verbundenen Risiken nur in Anlegung eines strengen Maßstabes zu vertreten. Transparenz und Nachvollziehbarkeit sind letztlich die Basis, um Vertrauen in das administrative System nicht zu untergraben. Definierte Einsatzprofile, Versionierung und Auditing der KI-Modelle sind Maßnahmen, die neben der Schulung der Nutzerinnen und Nutzer oberste Priorität haben.

Im Rahmen eines umfassenden Change-Managements muß dabei nicht nur ein Großteil der Prozesse neu gedacht werden, auch müssen Grenzen, Risiken und die Handhabung der KI-Systeme in der Bundeswehr fester Bestandteil der Befähigung für die Arbeit im Stabsdienst werden – diese Herausforderungen werden aktuell mit Hochdruck angegangen.

Gefechtsfeld-Services — Anwendungsfelder und operative Einordnung

Der Kern des Artikels widmet sich nun den Gefechtsfeld-Anwendungen, wobei aus Sicherheitsgründen technische und konkrete Details bewusst ausgeklammert bleiben müssen. Stattdessen sollen Funktionen, Integrationspunkte und betriebliche Implikationen auf einem konzeptionellen Niveau dargestellt werden.

Wahrnehmung und Erkennung („Find / Fix“)

KI-Methoden verbessern die Fähigkeit, relevante Signale aus heterogenen Sensoren zu extrahieren. In der Bilderkennung und Videoanalyse helfen automatische Detektion, Klassifizierung und Priorisierung von Objekten in Luft‑, Boden- sowie Seeaufnahmen und die automatische Markierung verdächtiger Bewegungen führt zur schnelleren menschlichen Wahrnehmung. Sensorfusion beschreibt die Zusammenführung von optischen, Radar‑, akustischen und SIGINT-Daten zu einem kohärenten Lagebild. KI kann dabei Inkonsistenzen erkennen, Anomalien markieren und Kontext-Vorschläge erzeugen. Die ständige Lageaktualisierung rundet den Schritt ab: Modelle, die Muster in Bewegungen oder Signalen identifizieren und so Hinweise auf sich verändernde Bedrohungen geben, unterstützen „Operateure“ in hohem Maße bei der Bewertung der Lage.

Ziel-Priorisierung und Entscheidungsunterstützung („Track / Target / Engage“)

In der Ziel-Verfolgung, Priorisierung und Entscheidungsunterstützung („Track / Target / Engage“) ist festzuhalten, daß KI in der Bundeswehr keine eigenständigen „Schießbefehle“ liefern soll, sondern als Hilfsmittel für den Menschen dient. Sie kann Priorisierungsvorschläge liefern, indem sie etwa anzeigt, welche Ziele weiterverfolgt oder an andere Kräfte zur Bekämpfung weitergegeben werden sollten. Ebenso kann sie bei der Risiko- und Kollateralschadenabschätzung helfen, indem sie Entscheidungsoptionen mit wahrscheinlichen Konsequenzen abgleicht. Die juristische und ethische Verantwortung verbleibt dabei jedoch stets beim Menschen. Schließlich kann KI auch die Prüfung von Alternativen in Feuerleitprozessen beschleunigen, etwa indem sie Optionen aufzeigt, welche Effektoren am sinnvollsten herangezogen werden sollten, ohne dabei selbst aktiv in den Prozess einzugreifen.

Wirkungserfassung („Assess“)

In der Wirkungserfassung („Assess“) geht es vor allem um die „Post-Engagement“-Analyse. Hierbei unterstützen KI-Systeme die automatische Auswertung von Effekten nach einem Einsatz, beispielsweise ob ein Ziel tatsächlich neutralisiert wurde, basierend auf Bild- und Sensordaten. Durch Rückmeldungen entstehen zudem Lernschleifen, mit denen sich Erkennungs- und Vorhersagemodelle kontinuierlich verbessern lassen – immer unter der Bedingung, daß der Mensch die finale Kontrolle behält.

„Edge-Computing“ und kleinteilige Modelle

Von besonderer Bedeutung sind die Entwicklungen im Bereich des „Edge-Computing“: Hierbei geht es darum, kleine, robuste KI-Modelle direkt auf taktischen Plattformen wie Drohnen, Sensoren oder führbaren Beobachtergeräten einzusetzen. Diese Modelle können erste Klassifikationen vornehmen und lediglich Meta-Daten oder priorisierte „Clips“ weiterleiten. Auf diese Weise lässt sich der Kommunikationsbedarf verringern, und die Systeme können auch dann noch operieren, wenn die Netzwerkeinbindung gestört oder umkämpft ist.

Autonomiegrade und „Mensch-in-der-Schleife“

Bei allen Gefechtsfeld-Anwendungen gilt der fundamentale Grundsatz, daß Menschen die finalen, legal-ethischen Entscheidungen verantworten. KI-Unterstützung darf sowie muß Entscheidungsprozesse beschleunigen und auch automatisch letale Aktionen ohne direkte menschliche Kontrolle auslösen – alles andere wäre in Zeiten der Hochautomatisierung unzweckmäßig. Mit Blick auf den konkreten Ausprägungsgrad von Autonomie muß das Maß an operativer und strategischer Verantwortung beim Einsatz dieser Systeme – sowohl rechtlich, als auch politisch – nach klaren und verbindlichen Regeln definiert werden. Dies gilt in besonderem Maße für Systeme mit offensiv-taktischem Bezug (z. B. „Loitering- Munition“). Solche Systeme werden in der öffentlichen Debatte besonders kritisch betrachtet. Aus nachvollziehbaren Gründen können an dieser Stelle keine operativen Prinzipien diskutiert werden. Herauszuheben ist aber, daß bei Einsatz, Prüfung und Zulassung dieser Systeme, die Technik strengen Regeln folgen muß (Völkerrecht, deutsches Recht, Gewährleistung der Unterscheidungs- und Verhältnismäßigkeitsprinzipien). Auch Verantwortungs- und Haftungsregelungen spielen eine zentrale Rolle: Wer entscheidet, wer prüft vor, während und nach einem Einsatz — diese Fragen sind zuvorderst politisch, dann militärisch und zuletzt technisch zu klären.

Risiken, Grenzen und betriebliche Anforderungen

Bei aller Euphorie über die Möglichkeiten eines Post-Humanen-Gefechtsfeldes ist die Technik, mit Blick auf Robustheit und Generalisierbarkeit, immer noch mit großen Herausforderungen behaftet. KI-Modelle sind oft empfindlich gegenüber veränderten Umgebungen oder gegnerischen Täuschungen (z.B. adversariale Manipulationen). Auch die Datenqualität zum Training der Modelle spielt eine große Rolle. Veraltete, verfälschte Daten oder ungeeignete Trainingsdaten führen zu Fehlalarmsituationen oder verpassten Erkennungen. Auch Übervertrauen könnte zum Problem werden: Automatisierte Vorschläge dürfen nicht als unfehlbar behandelt werden.

In organisatorischer und rechtlicher Hinsicht stellen sich besondere Anforderungen: So müssen alle KI-Systeme einer konsequenten Zertifizierung und Prüfung unterzogen werden. Dies umfasst realistische Testszenarien, klare Prüfraster und eine unabhängige Evaluierung, um sowohl die Funktionsfähigkeit, als auch die Sicherheit der Systeme zu gewährleisten. Ebenso zentral ist eine robuste Betriebs-IT- und Sicherheitsarchitektur: Modelle müssen abgesichert sein, Datenpfade klar getrennt, Updates verschlüsselt und Schnittstellen eindeutig definiert werden. Parallel dazu kommt der Aus- und Weiterbildung des Personals eine Schlüsselrolle zu. Nur wenn Nutzerinnen und Nutzer in der Lage sind, „KI-Outputs“ zu verstehen, kritisch einzuordnen und gegebenenfalls zu hinterfragen, lässt sich ein verantwortungsvoller Betrieb sicherstellen. Auch im Bereich „Governance“ und Ethik sind klare Vorgaben notwendig. Verbindliche Regelwerke müssen definieren, für welche Einsatzzwecke KI-Systeme zugelassen sind, wo Interventionsschwellen liegen und welche Verantwortlichkeiten bestehen. Transparenz ist ein zentrales Gebot: Soweit es technisch möglich ist, müssen Systemgrenzen erklärt und Entscheidungen nachvollziehbar gemacht werden. Ergänzend ist die Abstimmung mit internationalen Partnern unverzichtbar, damit ein gemeinsamer Rechtsrahmen eingehalten und kompatible Standards gewahrt werden können. Aus diesen Anforderungen ergeben sich konkrete Empfehlungen für die Einführung und Betreuung von KI-Diensten in den Streitkräften. Ein stufenweiser „Rollout“ bietet sich an, bei dem zunächst administrative und risikoärmere Anwendungen eingeführt werden, während parallel Testumgebungen und Evaluationszentren für Gefechtsfeld-„Use-Cases“ aufgebaut werden. Klare Verantwortlichkeiten sind dabei essenziell: Es muß eindeutig geregelt sein, wer Modelle genehmigt, wer sie betreibt und wer rechtlich die Verantwortung trägt. Ebenso wichtig ist ein konsequent menschzentriertes Bedienkonzept. Die Benutzeroberflächen müssen so gestaltet sein, daß Quellen für Vorschläge schnell erkennbar und verständlich sind. Um die Zuverlässigkeit sicherzustellen, bedarf es robuster Test- und Zertifizierungsprozesse, die simulationsgestützt und durch strenge Feldversuche abgesichert sind. Schließlich ist die enge Koordination mit Bündnispartnern notwendig, damit gemeinsame Standards, Interoperabilität und abgestimmte Sicherheitsanforderungen von Anfang an gewährleistet sind.

Fazit

KI ist ein Multifunktionswerkzeug, das im administrativen Bereich Effizienzgewinne und Entlastung bietet, während sie auf dem Gefechtsfeld die Wahrnehmungs‑, Analysefähigkeit steigert, damit zur altbekannten Führungs- und so schließlich zur Wirkungsüberlegenheit führen kann. Beide Nutzungsbereiche verlangen jedoch ein stringentes „Governance“- und Sicherheitsregime. Nur so lassen sich Chancen nutzen und zugleich die Risiken – technisch, rechtlich und ethisch – beherrschbar halten. Heutige Entscheidungsträger müssen daher nicht nur in Technologie investieren, sondern vor allem in Prüf‑, Ausbildungs- und Regelungsstrukturen, die den Einsatz von KI verantwortbar machen.

Der Autor ist als Referent für Cyber-Operationen sowie als Beauftragter für Künstliche Intelligenz im Strategiereferat des Kommandos Cyber- und Informationsraum eingesetzt.